Vietare chatGpT non risolve, ma è cambiato il campo di gioco

Big data e IA La questione più scottante sono i dati usati da OpenAI per addestrare il sistema, scelti sia tra le fonti presenti in internet, sia tra corpora acquisiti da fornitori di terza parte. Il Garante ha alzato la bandierina del guardalinee: se siamo di fronte a uno scrivente autonomo, va rispettata la regola di chi pubblica ciò che scrive

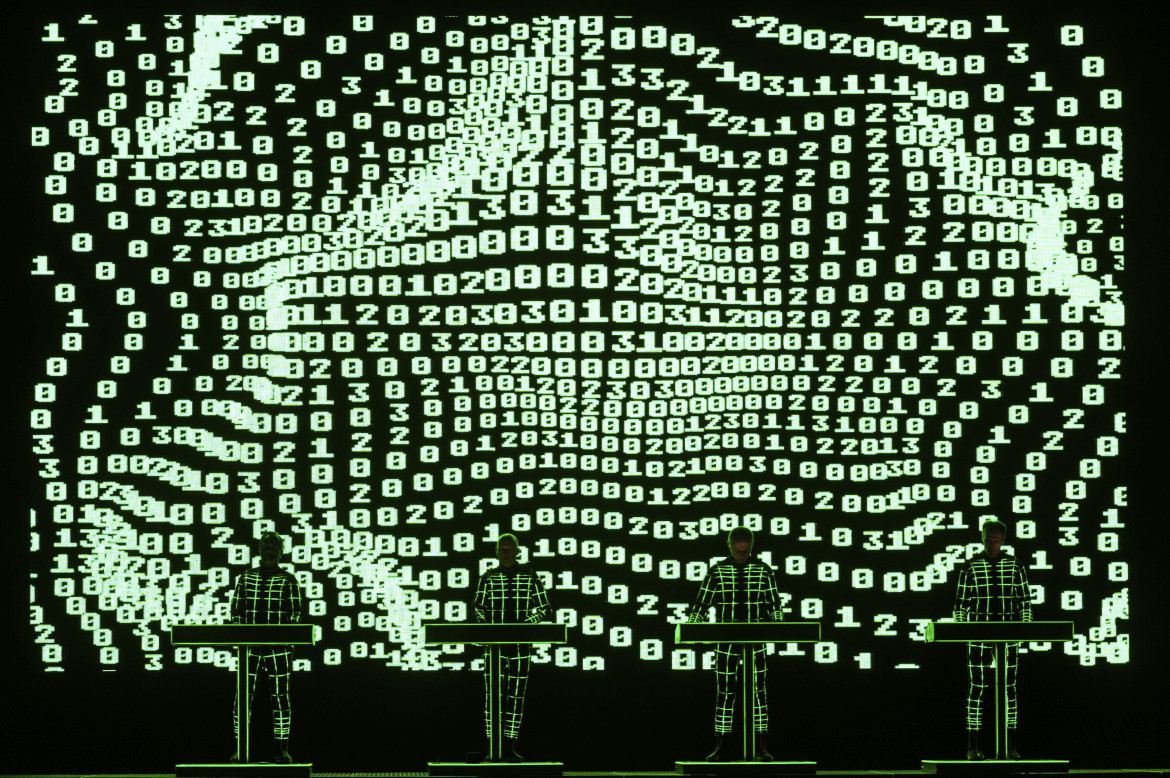

Un’illustrazione di ChatGPT

Un’illustrazione di ChatGPTBig data e IA La questione più scottante sono i dati usati da OpenAI per addestrare il sistema, scelti sia tra le fonti presenti in internet, sia tra corpora acquisiti da fornitori di terza parte. Il Garante ha alzato la bandierina del guardalinee: se siamo di fronte a uno scrivente autonomo, va rispettata la regola di chi pubblica ciò che scrive

Il provvedimento del Garante per la Privacy del 30 marzo scorso nei confronti di OpenAI, la società che gestisce la piattaforma di ChatGPT, il servizio di chat che è in grado di interagire con gli utenti in vere conversazioni, ha sollevato un vespaio di polemiche.

Siamo tutti d’accordo che sia ingiusto risolvere le difficoltà poste dalle tecnologie esclusivamente a colpi di divieti, soprattutto se solo italiani. Tuttavia, nell’intervento del Garante ci si limita a una provvisoria sospensione del trattamento dei dati di coloro che si trovano in territorio italiano, adottando una misura temporanea, connessa all’apertura di un’istruttoria. OpenAI ha deciso di interrompere il servizio in Italia, non potendo garantire la tutela dei dati, come richiesto dal Garante. Scegliendo di drammatizzare la questione.

La redazione consiglia:

Stop a ChatGPT in Italia, uso dei dati non autorizzatoSono diversi i profili sollevati nell’istanza dell’Autorità. Si tratta di questioni connesse, ma distinte.

Un’osservazione riguarda il malfunzionamento avvenuto in marzo, che ha comportato la visibilità incrociata delle conversazioni di altri utenti, errore su cui Sam Altman, il CEO di OpenAI, ha già chiesto perdono su Twitter.

Il secondo problema si riferisce al divieto di accesso previsto per i minori di 13 anni, rispetto ai quali non ci sono controlli.

La questione più scottante, però, è relativa ai dati usati da OpenAI per addestrare il sistema, scelti sia tra le fonti presenti in internet, sia tra corpora acquisiti da fornitori di terza parte.

Questo aspetto merita attenzione, considerando che tutti i sistemi algoritmici usati per fare raccomandazioni, dai motori di ricerca, alle piattaforme di streaming e di social networking, ai consigli per gli acquisti di Amazon utilizzano dati personali per fornire consigli e costruire criteri di visibilità dei contenuti che ospitano.

La differenza consiste nel fatto che le altre piattaforme si autodefiniscono come fornitori di suggerimenti di cui non si assumono la paternità, mentre ChatGPT supera questa soglia, offrendo risposte, anche relativamente a informazioni sulle persone, peraltro spesso inventate e scorrette.

La redazione consiglia:

ChatGpt, Antonio Casilli: Il lato oscuro dell’algoritmo è la forza lavoroFronteggiamo quindi il problema dell’autorialità dei contenuti, proprio a causa del carattere di generatività di questi algoritmi, che è la grande novità dei Large Language Models (LLM) a cui appartiene GPT4. Gli altri sistemi di raccomandazione hanno sempre sostenuto, magari a torto, ma in modo convincente, l’assenza di un carattere editoriale nei meccanismi di visibilità che selezionano link consigliati, prodotti suggeriti, notizie organizzate e rese accessibili.

La mancanza di contenuti originali ha permesso loro di sottrarsi alla responsabilità dei loro risultati, sebbene talvolta si siano trovati nella scomoda situazione di dover giustificare perché i loro suggerimenti avessero modificato le scelte politiche delle persone.

Nel caso del sistema di chat è complicato non rispondere dei suoi testi. Benché tecnicamente il sistema funzioni in modo simile alle piattaforme, con suggerimenti di accostamento tra parole, costruiti in base alla probabilità di trovarsi collegati alla lista delle espressioni usate dall’interlocutore, è difficile sostenere che non si tratti di sue scelte. Il motivo è che il risultato è generato in modo univoco come una scelta editoriale generativa, non attraverso una lista di risposte alternative.

Di chi è la responsabilità della descrizione di una persona fornita da ChatGPT e completamente inventata, ingannevole e sbagliata?

Gli stessi motori di ricerca sono tenuti a rispettare il diritto all’oblio e cancellare le informazioni, magari anche vere, ma passate, che gli utenti trovassero offensive e lesive della loro reputazione. Quale regime di autorialità e di responsabilità testuale vale per ChatGPT?

Se copiasse dovrebbe rispondere di plagio, se non citasse le fonti. Ma non copia, crea contenuto ex novo, come esito di un addestramento, che però funziona solo come allenamento, riscaldamento per la produzione indipendente. Se siamo di fronte a una agency, un attore, uno scrivente autonomo, è necessario rispettare le regole di tutti quelli che pubblicano ciò che scrivono.

Vietare non risolve le contraddizioni, ma il provvedimento del Garante potrebbe essere un’occasione per esaminare, senza retorica nerd, i vestiti nuovi dell’imperatore. E se l’imperatore fosse nudo?

Se non potessimo fidarci di quello che scrive ChatGPT e dovessimo continuamente fare gli editor delle sciocchezze della chat, per discriminare le cose giuste da quelle sbagliate? Chi deve pagare il prezzo di correggerlo? Il fatto di essere un sistema socio-tecnico lo rende forse legibus solutus, sovrano unico dei contenuti che produce?

Frenare l’innovazione non funziona. Il provvedimento del Garante è temporaneo e probabilmente si risolverà senza grandi cambiamenti per OpenAI, ma è come una bandierina del guardalinee: se il campo di calcio ha cambiato dimensioni, è bene non scoprirlo a partita in corso.

I consigli di mema

Gli articoli dall'Archivio per approfondire questo argomento