E se ChatGpt fosse un autore del New York Times?

Intelligenza Artificiale Nella causa del giornale americano a OpenAi e Microsoft la cosa che risulta più difficile da capire è come, benché un sistema generativo pre-addestrato riproduca (in certe condizioni) le frasi lette negli articoli, quelle frasi, nel modello, fisicamente non esistano

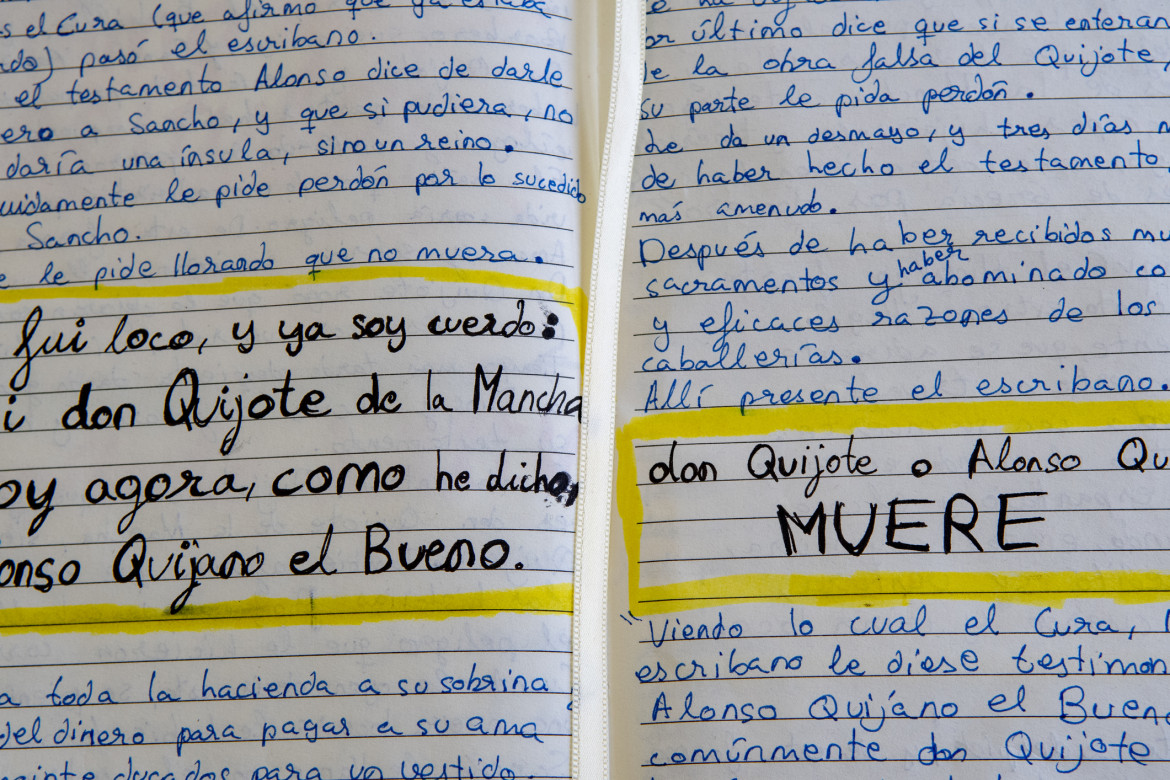

Jorge Luis Borges ha messo in prosa le più grandi provocazioni intellettuali del XX Secolo. Tra le più sconcertanti c’è quella di Pierre Menard, autore del “Chisciotte” (Finzioni, 1944). Menard, poeta simbolista, scrive un testo che corrisponde, parola per parola, a El ingenioso hidalgo Don Quijote de la Mancha che Cervantes vergò nel Seicento.

Tuttavia, rivendica Borges per Menard, non si tratta dello stesso romanzo. Scrive Borges:

Il testo di Cervantes e quello di Menard sono verbalmente identici, ma il secondo è quasi infinitamente più ricco. (più ambiguo diranno i suoi detrattori; ma l’ambiguità è una ricchezza). Il raffronto tra la pagina di Cervantes e quella di Menard è senz’altro rivelatore. Il primo, per esempio, scrisse (Don Chisciotte, parte I, capitolo IX):

…la verità, la cui madre è la storia, emula del tempo, deposito delle azioni, testimone del passato, esempio e notizia del presente, avviso dell’avvenire.

Scritta nel secolo XVII dall’«ingenio lego» Cervantes, quest’enumerazione è un mero elogio retorico della storia. Menard, per contro, scrive:

…la verità, la cui madre è la storia, emula del tempo, deposito delle azioni, testimone del passato, esempio e notizia del presente, avviso dell’avvenire.

La storia, madre della verità; l’idea è meravigliosa, Menard, contemporaneo di William James, non vede nella storia l’indagine della realtà, ma la sua origine. La verità storica, per lui, non è ciò che avvenne, ma ciò che noi giudichiamo che avvenne.

Se la provocazione di Borges-Menard va in qualche modo a segno, allora è possibile, forse probabile, che il New York Times perda la causa contro OpenAI.

La redazione consiglia:

Il New York Times porta in tribunale OpenAi e MicrosoftLa querela del giornale gira attorno al fatto che “alimentato da grandi modelli del linguaggio [LLM] che contengono copie dei contenuti del Times, [ChatGPT] genera risultati che recitano il contenuto del Times parola per parola, lo riassumono strettamente (closely) e ne imitano lo stile espressivo, come dimostrato da decine di esempi”.

Se nel generare (frammenti) di un testo già noto, ChatGPT dimostrerà di saper creare comunque un contenuto originale con un ragionamento tutto suo, potrà avere buon gioco.

Non c’è dubbio che gli articoli della prestigiosa testata newyorkese abbiano contribuito in modo sostanziale all’addestramento di ChatGPT, e può darsi che l’uso che ne è stato fatto non abbia del tutto rispettato le terms and conditions stabilite da chi li rese a suo tempo disponibili.

Ma probabilmente è su quel “generare il contenuto del Times parola per parola” e quel “riassumere strettamente” che gli avvocati daranno fondo all’eloquenza, gli informatici dispiegheranno i loro diagrammi, linguisti e filosofi pronunceranno i loro arcani, e i giudici dovranno cercare di capire qualcosa.

Certo non sarà facile, per chi si è formato sui libri di giurisprudenza, orientarsi nel combinato disposto dell’intelligenza artificiale, della proprietà intellettuale delle parole e di certe sottili questioni di ermeneutica letteraria.

Ma la posta in gioco è tale che da questo processo dovrà per forza uscire qualcosa di simile a un punto fermo.

La redazione consiglia:

Se la deregulation della Silicon Valley prende piede in EuropaLa cosa che risulta più difficile da capire è come, benché un sistema generativo pre-addestrato riproduca (in certe condizioni) le frasi lette nei testi, quelle frasi, nel modello, fisicamente non esistano.

Quello che c’è sono le tracce numeriche che queste hanno lasciato nei miliardi di neuroni (parametri) in cui si incarna il modello linguistico. Queste tracce guidano la generazione delle frasi un po’ come i chiodi della famosa scatola inventata da Sir Francis Galton nell’Ottocento guidano le biglie nella loro caduta.

Essi sono disposti in modo tale da deviarne casualmente il percorso, così che alla fine le biglie si accumulano in contenitori alla base della scatola, formando una campana che riflette una “distribuzione normale”. Nessun chiodo, da solo, determina la posizione finale di alcuna biglia, che è soggettivamente libera di rotolare in qualsiasi punto della distribuzione. L’energia iniziale della biglia, inoltre, conta qualcosa. Tuttavia, le forme che si ottengono sono normalmente, appunto, “normali”.

Si accusa chi costruisce quelle “macchine di Galton” che sono i Language Model di piantare i loro chiodini non a caso, non con disegni originali, ma sulla base di testi estratti da varie opere, i quali, elaborati in un certo modo, fanno sì che le distribuzioni di parole ottenute negli eventi generativi riflettano, talvolta puntualmente, i testi originali.

Ma il fatto che nel processo di distribuzione delle biglie-parola si possano in effetti riprodurre le medesime sequenze dei testi usati per l’addestramento resta un fatto meramente probabilistico. Il plagio, per come lo intendiamo nei nostri ordinamenti, è al contrario l’esercizio di una precisa volontà di indebita appropriazione.

Il Menard di Borges rivendica la propria autorialità nel produrre, con un’intenzione tutta sua, le frasi del Chisciotte. In un processo per plagio, un giudice probabilmente lo condannerebbe. Ma il caso degli automi linguistici è più complesso, sia sotto il profilo tecnico, sia sotto quello giuridico.

È difficile rintracciare nelle reti neurali il progetto di appropriarsi di specifiche locuzioni, o dimostrare la volontà, da parte dei progettisti, di imitare lo “stile espressivo” di ciò su cui sono addestrate. Si tratta in fin dei conti di epifenomeni statistici, peraltro facilmente emendabili.

Sembra inoltre difficile riconoscere a qualche autore l’esclusiva del racconto di fatti e circostanze di pubblico dominio, sia pure con uno stile caratteristico. Si può pensar male di ChatGPT, ma si osservi che il suo business non è la contraffazione.

Vedremo come andrà a finire. Di sicuro la causa del New York Times contro OpenAI sarà la resa dei conti di una tensione che si accumula già da alcuni anni e dal suo esito dipenderanno molte cose. Per intanto, le vicende giudiziarie delle nuove macchine parlanti portano alla ribalta in modo eclatante la ricerca sulla poetica formale che fu già di Borges e di Calvino.

Errata Corrige

L’8 gennaio 2024 Open Ai ha risposto con un comunicato alle contestazioni del New York Times

I consigli di mema

Gli articoli dall'Archivio per approfondire questo argomento