L’esplosione ribelle contro l’Impero dell’IA generativa

Tutte le cose hanno origine nel conflitto (polemos) , diceva Eraclito, o nella dialettica, se preferiamo la più tenue espressione di Hegel. Marx e i suoi followers hanno in seguito capito che nel conflitto può nascere anche la falsa coscienza e l’inautentico.

Tutto questo si vede anche nello sviluppo attuale dell’Intelligenza Artificiale cosiddetta “generativa”. OpenAI, inventrice di GPT, diceva che l’avrebbe “democratizzata”. Ora invece, Microsoft adiuvantibus, la startup di Sam Altman sta lavorando, in gara con altri bei soggetti, al più grande disegno monopolistico che il capitalismo abbia mai ideato: l’Intelligenza artificiale generale, cioè la coscienza dell’umanità in una manciata di profittevoli automi.

Ma la dialettica vuole che ad ogni disegno finisca prima o poi per contrapporsi un disegno uguale e contrario.

Migliaia di language model generativi “aperti”, cioè ovunque liberamente utilizzabili, vanno da qualche tempo popolando la piattaforma Huggingface, l’hub storico delle tecnologie linguistiche open source, che potrebbe somigliare alla Rebel Alliance di Guerre stellari se non fosse in realtà un geniale business.

Questi modelli aperti sono sviluppati e regalati da startup, università o perfino singoli ricercatori, ma anche da colossi come Meta che per qualche motivo hanno interesse ad agitare le acque.

Come è possibile che una tale varietà di soggetti sia oggi in grado di addestrare reti neurali di tipo transformer per produrre modelli linguistici generativi?

Il fatto è che ormai le architetture e le procedure di questa fabbricazione sono anch’esse in gran parte open, e che molti dati di addestramento sono attingibili o a loro volta generabili, sicché con le giuste competenze e con il giusto hardware quasi chiunque, in linea di principio, può avventurarsi nell’impresa.

La combinatoria di metodi standardizzati e intuizioni innovative è vertiginosa, e gli hacker delle tecnologie linguistiche la stanno implacabilmente esplorando. Ne vedremo delle belle.

La redazione consiglia:

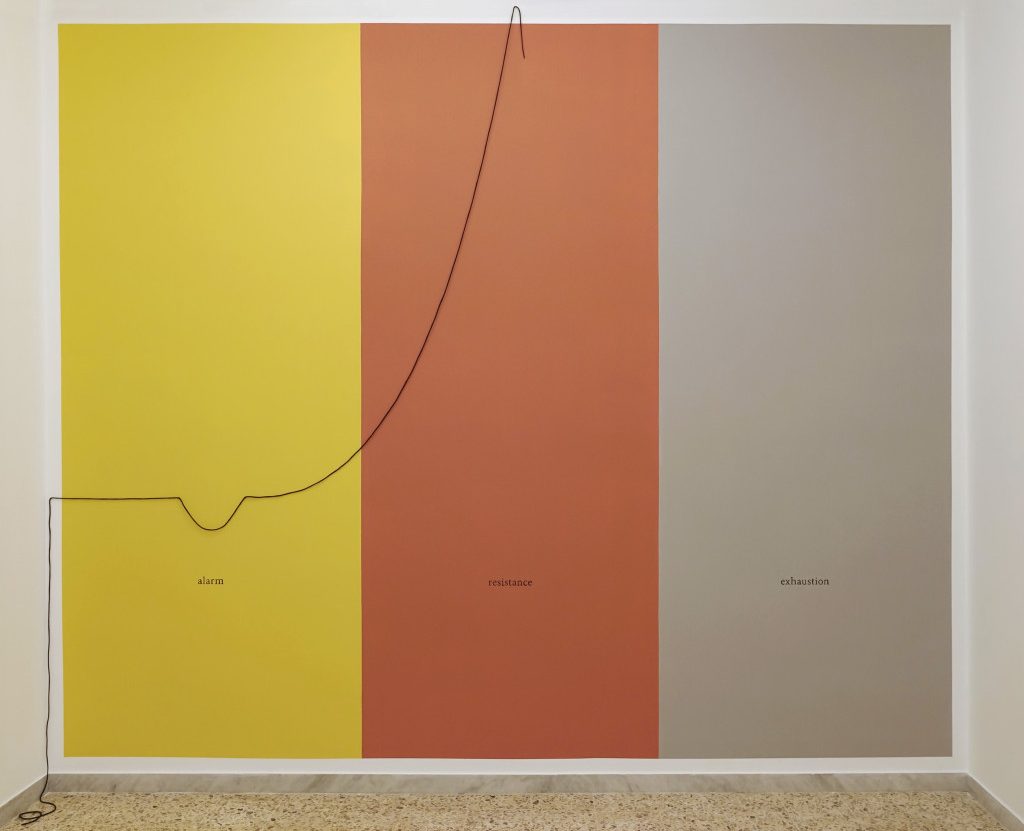

ChatGpt non s’ha da fare, senza scienza democraticaIn questa effervescenza emergono due problemi: quello dell’allineamento tra i comportamenti prodotti dagli automi e quelli attesi dagli umani, che include il tema dell’etica, e quello della condizione di minorità delle lingue diverse dall’inglese.

I due problemi sono in qualche modo interconnessi. Dando per buono che le tecnologie per produrre modelli linguistici generativi stiano diventando commodities, la qualità dei modelli prossimi venturi dipenderà in modo cruciale da come tali problemi saranno affrontati.

Il primo e fondamentale ingrediente di un language model è un’enorme quantità di parole. Poiché la buona letteratura non basta, bisogna dare fondo alla testualità internettiana, notoriamente inquinata da tossine verbali di ogni tipo.

Eliminarle del tutto è difficile: anche se è possibile filtrare il turpiloquio in modo abbastanza semplice, molta di questa tossicità giace sul piano assiologico, cioè dei valori. Il “Manifesto della razza” del 1938, col suo carico di fascistiche fandonie, passerebbe nel filtro indenne.

Oltre a rigurgitare le tossine ingerite dai testi, un language model generativo, uscito dalla sala di lettura, produrrebbe anche (e soprattutto) frasi senza senso. Ciò si deve al fatto che ciò che l’automa, nella prima fase, ha imparato è solo la probabilità che una parola segua a quelle che la precedono. Sebbene questo calcolo sia molto sofisticato, e il co-testo considerato abbastanza ampio, si tratta pur sempre di assonanze prive di quella cosa che chiamiamo solitamente “ragione”.

Si rende dunque necessaria una seconda fase di addestramento, il cui scopo è quello di instradare il generatore verso il senso compiuto, la verecondia, l’utilità.

Sappiamo che per quel ChatGPT che ha portato l’AI alla ribalta si è trattato più che altro di interagire con esseri umani, cosa che ha richiesto tempo e denaro.

La redazione consiglia:

ChatGpt, Antonio Casilli: Il lato oscuro dell’algoritmo è la forza lavoroMa oggi vi sono tecniche che rendono questa seconda fase assai più semplice, a condizione di avere abbastanza esempi di coppie input \ output virtuose e desiderabili.

Queste si ricavano in genere da risorse disponibili come Reddit TL;DR, che esemplifica il modo un cui da un post (input) si può ricavare un riassunto (output), ma al limite si possono fabbricare ad hoc. In questo tipo di risorse dovrà incarnarsi l’ethos linguistico che si vuole conferire all’automa.

Le comunità nazionali non anglofone stanno affrontando il problema di produrre generatori efficaci per la propria lingua.

Le strade sono due: costruirli ab imis fundamentis da testi in quella lingua oppure raffinare modelli multilinguistici aperti, specialmente quelli portati in dono da chi ha molte risorse per produrli.

Nel primo caso si pagherà il purismo col doversi far carico della sia disintossicazione sia degli allineamenti. Nel secondo caso, pur sapendo che all’inizio il modello potrà parlare come Salvatore nel Nome della rosa, si beneficerà dell’ethos con cui l’originale è stato addestrato. Ciò avviene anche in virtù di un effetto chiamato transfer learning, che fa parte degli arcani delle grandi reti neurali.

Il primo modello puramente italiano, quel Minerva dell’Università Sapienza che si è esposto alla gogna internettiana per certe sue esternazioni, rientra nel primo caso, ma è (dichiaratamente) privo di allineamento, da cui l’interessante (ma triste) effetto-Vannacci della sua prosa. Nulla di strano per la scienza, però l’annuncio faceva pensare che venisse sfornata una pizza, mentre invece si trattava solo dell’impasto.

La redazione consiglia:

Minerva, l’IA italiana al bivio tra Vannacci e ManzoniNella via italiana all’AI linguistica, la nostra Università, ancora pregna di un certo Spirito della Nazione di humboldtiana memoria, gioca un ruolo importante. È bene che lo faccia con la piena consapevolezza dei “tempi interessanti” che stiamo vivendo.

Tempi in cui le comunità di ricerca e sviluppo sono trasversali, fortemente interconnesse e tremendamente dialettiche. La prima competenza da trasmettere a studenti e studentesse è la curiosità intellettuale, lo spirito di collaborazione e l’umiltà.

I consigli di mema

Gli articoli dall'Archivio per approfondire questo argomento