L’algoritmo della vergogna e le distorsioni del welfare

Un'inchiesta in Francia Uno dei pezzi più importanti del welfare, la Caisse d’allocations familiales (Caf), l’ente che si occupa degli aiuti sociali alle famiglie in difficoltà, per molto più di un decennio ha funzionato affidandosi solo a un algoritmo che discriminava i precari e i più svantaggiati. Dopo anni di battaglia Quadrature du Net è riuscita ad analizzare il codice sorgente. Ecco i risultati

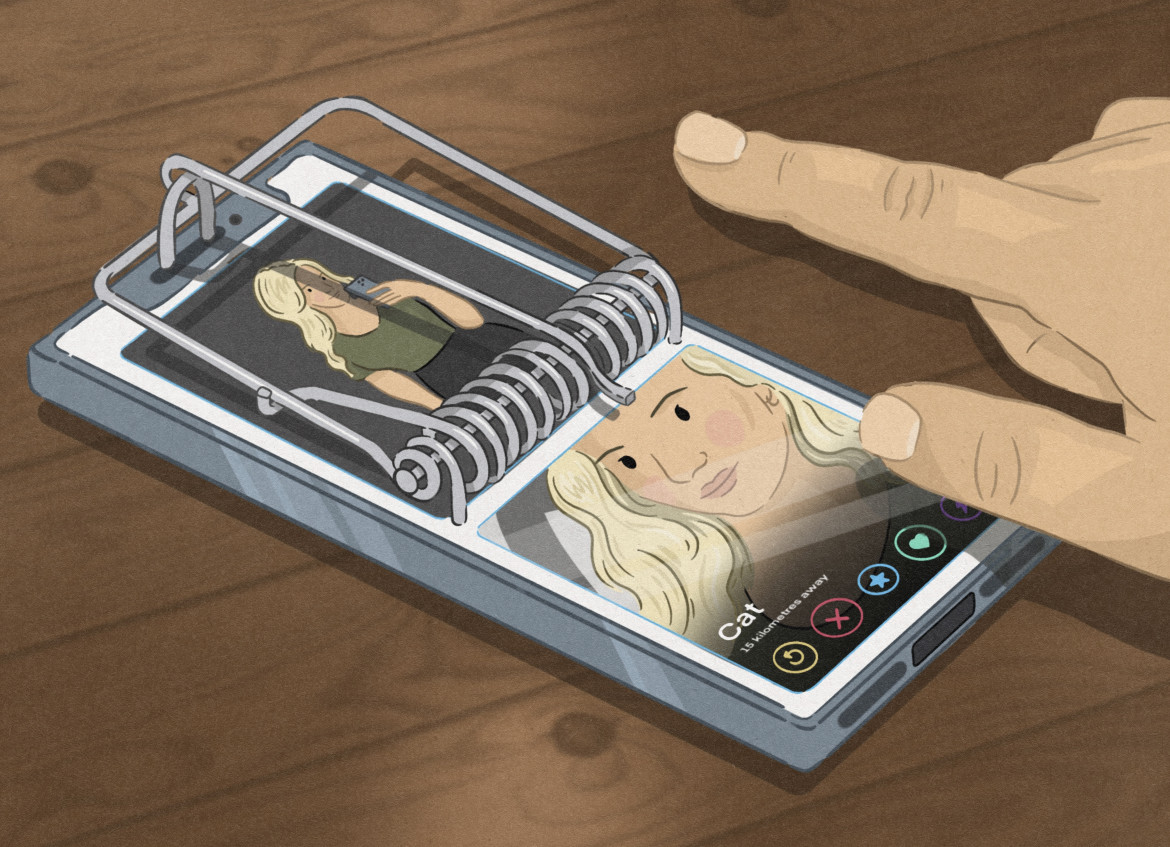

L’algoritmo della vergogna. Perché quel futuro distopico, paventato da Altman, Musk, Zuckerberg e tutti gli altri “proprietari” dell’ultima frontiera della tecnologia, quel futuro dove robot e automazione aggrediranno l’umanità, è già qui.

Con una differenza sostanziale, però, rispetto a quel che raccontano i boss delle Big Tech: che quegli strumenti non aggrediscono tutti, non colpiscono un’umanità indefinita ma solo gli ultimi. A vantaggio dei primi.

E quel futuro è già qui. In Francia, per fare l’ultimo esempio.

Qui uno dei pezzi più importanti del welfare, la Caisse d’allocations familiales (Caf), l’ente che si occupa degli aiuti sociali alle famiglie in difficoltà, per molto più di un decennio ha funzionato affidandosi solo a un algoritmo. Ha preso decisioni, ha escluso beneficiari, ha aggravato la condizione di migliaia di persone affidandosi ad un algoritmo “costruito” e progettato solo per “sospettare” e colpire gli ultimi: i precari, i portatori di handicap, le donne sole, chi non poteva pagare l’affitto.

Stavolta non è una denuncia generica. La Quadrature du Net, una delle più serie, autorevoli, combattive associazioni per i diritti sociali e digitali in Europa – non una delle tante che si limita a firmare appelli on line – assieme a due collettivi di ricerca – Stop Controls e Changer de Cap – dopo una lunga, estenuante battaglia è riuscita ad ottenere il codice sorgente dell’algoritmo utilizzato dalla Caf.

Lo ha fatto sfruttando una norma che obbliga le pubbliche amministrazioni a fornire informazioni sul proprio operato. C’è riuscita superando centomila ostacoli frapposti dalla burocrazia e non ha ottenuto un risultato pieno: perché l’ente ha dovuto concedere la trasparenza sull’algoritmo utilizzato tra il 2010 e il 2018, non su quello in uso oggi.

Ma il risultato è stato lo stesso clamoroso. Perché il codice sorgente è quello che definisce il “flusso d’esecuzione” di un programma, è la sequenza di istruzioni. Per usare l’espressione della Quadrature è la “formula” utilizzata per istruire il suo funzionamento.

Quel codice sorgente è stato analizzato in ogni dettaglio (codice, elenco delle variabili, ponderazioni, ecc), anche qui con un lavoro lunghissimo. E dettagliatissimo. E’ venuta fuori la foto di una moderna distopia. Dove la filosofia della sorveglianza automatizzata si sposa con la “caccia” agli ultimi, ai precari, a chi è in difficoltà. “Sospettati” di essere imbroglioni quasi di default.

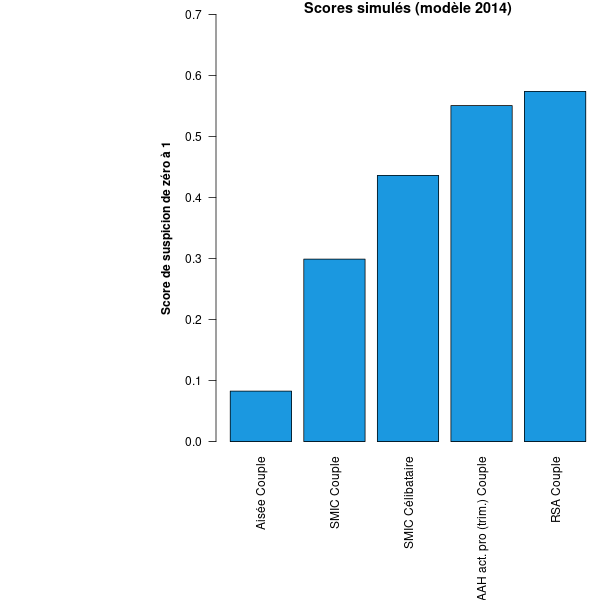

Perché il sistema algoritmico della Caf – introdotto nel 2011 per scoprire chi truffava sui sussidi – prevedeva (nessuno sa se lo faccia ancora oggi) uno strano sistema di classificazione. Un livello di rischio da zero a uno.

Ecco come funzionava: la Caf controllava e monitorava tante attività delle famiglie coinvolte. Qualcosa come trentadue milioni di persone (metà della popolazione francese), tredici milioni di bambini compresi. Addirittura quanto tempo le persone stessero sul sito Web, quante email inviassero. Quanta benzina consumassero.

Una profilazione di massa che poi veniva integrata ogni mese per compilare i quaranta “criteri” che servivano alla Caf per stilare l’elenco delle famiglie “sospette”, alle quali inviare o chiedere ulteriori controlli. O alle quali, nel peggiore dei casi, togliere direttamente i sussidi in attesa di accertamenti.

Gli elementi per i quali si avanzava nella classifica del cittadino “sospetto” erano – nell’ordine – perdere ripetutamente un’occupazione, come accade ai precari, vivere in un quartiere periferico, essere destinatario di un altro aiuto – magari un sostegno agli affitti -, comporre una famiglia monoparentale. Peggio se composta solo da una donna. E ancora peggio, “il massimo del cinismo” scrive Quadrature, il tasso di sospetto cresceva se nella famiglia c’era un portatore di handicap.

Tra le variabili che aumentano il “punteggio di sospetto”, troviamo in particolare:

- Il fatto di avere redditi bassi

- Il fatto di essere disoccupati

- Il fatto di essere un beneficiario della RSA (Reddito di solidarietà attiva)

- Il fatto di vivere in un quartiere “svantaggiato”

- Il fatto di dedicare una parte significativa del proprio reddito al proprio affitto

- Il fatto di non avere un lavoro o un reddito stabile

- Colmo del cinismo: il fatto di beneficiare dell’indennità per adulti disabili (AAH) mentre si lavora è uno dei parametri che hanno un impatto più forte sul punteggio di un beneficiario.

Si potrebbe continuare – è ormai tutto verificabile on line per chi ha la pazienza di farlo – ma il senso è che, alla fine, correlando e ponderando le varie condizioni soggettive, “l’algoritmo della vergogna” obbligava l’istituzione a controllare quasi solo gli ultimissimi gradini della scala sociale. Chi era in condizioni disperate.

Stiamo parlando della Caf. Ma in Francia, algoritmi – dei quali nessuno conosce il codice sorgente – regolano il funzionamento anche dell’agenzia per la disoccupazione (France Travail, ex Pole Emploi), l’assicurazione sanitaria, il sistema pensionistico pubblico, la previdenza sociale per gli agricoltori (Sécurité Sociale Agricole). E nessuno ha intenzione di cambiare registro.

La redazione consiglia:

La sanità privata si affida a un algoritmo. Ma è assai razzistaPerché immediatamente dopo la pubblicazione dello studio della Quadrature, il direttore della Caf, Nicolas Grivel, ha risposto con un lungo articolo per dire in sostanza che loro, “non hanno nulla di cui arrossire, né scusarci: non abbiamo mai discriminato nessuno”.

Facile la controreplica: un algoritmo “pensato” per sospettare innanzitutto e quasi esclusivamente gli ultimi rientra esattamente nella definizione di discriminatorio.

Non può esistere un modello dell’algoritmo che non si rivolga ai più svantaggiati, e più in generale a coloro che si discostano dallo standard definito dai suoi progettisti. Non è necessario conoscere il dettaglio della formula dell’algoritmo per prevedere quali popolazioni saranno prese di mira perché è l’obiettivo politico dell’algoritmo – rilevare chi percepisce senza averne diritto – che determina la discriminazione.Quadrature du Net

Ma la storia dell’”algoritmo della vergogna” racconta molto altro. Questo sistema di sorveglianza, all’interno del tuttora generoso sistema di welfare francese, serve ad alleviare le spese in eccesso? E’ stato utile? Ha stanato i truffatori dando giustizia e certezze a chi ne aveva diritto?

A conti fatti, al termine di migliaia di “verifiche”, di richieste di rimborsi, di blocco dei sussidi, quell’algoritmo – stando alle cifre ufficiali – ha consentito di recuperare appena lo 0,2% delle somme spese.

Quel che non è quantificabile è invece il dramma delle famiglie che da un giorno all’altro si sono trovate “sotto inchiesta”. Investigate e senza difesa.

Soprattutto perché, secondo la Caritas francese, il Secours catholique, almeno il 30% circa di coloro che avrebbero diritto alle prestazioni sociali non fanno domanda, perché troppo lontani dall’amministrazione, perché è troppo difficile, perché male informati, ecc.

La redazione consiglia:

Insegnanti trasferiti, l’algoritmo non è la leggePurtroppo in questa battaglia Quadrature non ha potuto contare su molti alleati. Come se fosse un argomento da nerd. Come se l’automazione delle prestazioni sociali non sia un elemento che dovrebbe essere centrale nell’iniziativa dei sindacati e della sinistra.

I consigli di mema

Gli articoli dall'Archivio per approfondire questo argomento