I pappagalli stocastici volano basso

ChatGpt è un copione. Come quelli che stavano agli ultimi banchi a scuola, solo con diversi miliardi di strumenti in più. Un’affermazione tranchant che però parte da molte domande. Domande e dubbi: ma davvero una IA generativa elabora? S’inventa qualcosa di nuovo? Oppure molto più semplicemente copia e si limita a una gigantesca, enorme operazione di copia & incolla?

Che poi si può tradurre anche con: pensa o no? Ragiona o si limita ad eseguire? Il lui o il lei – lo si è detto – è l’intelligenza artificiale. Anzi, meglio: si parla dei large language model, gli LLM, i modelli linguistici di grandi dimensioni, un tipo particolare di intelligenza artificiale che utilizza reti neurali in qualche modo simili a quelle umane. Strumenti che sono in grado di generare testi, di rispondere a domande, di scrivere programmi. ChatGpt, per fare il nome più noto. ChatGpt e tutti gli altri chatbot arrivati a cascata nell’ultimo anno.

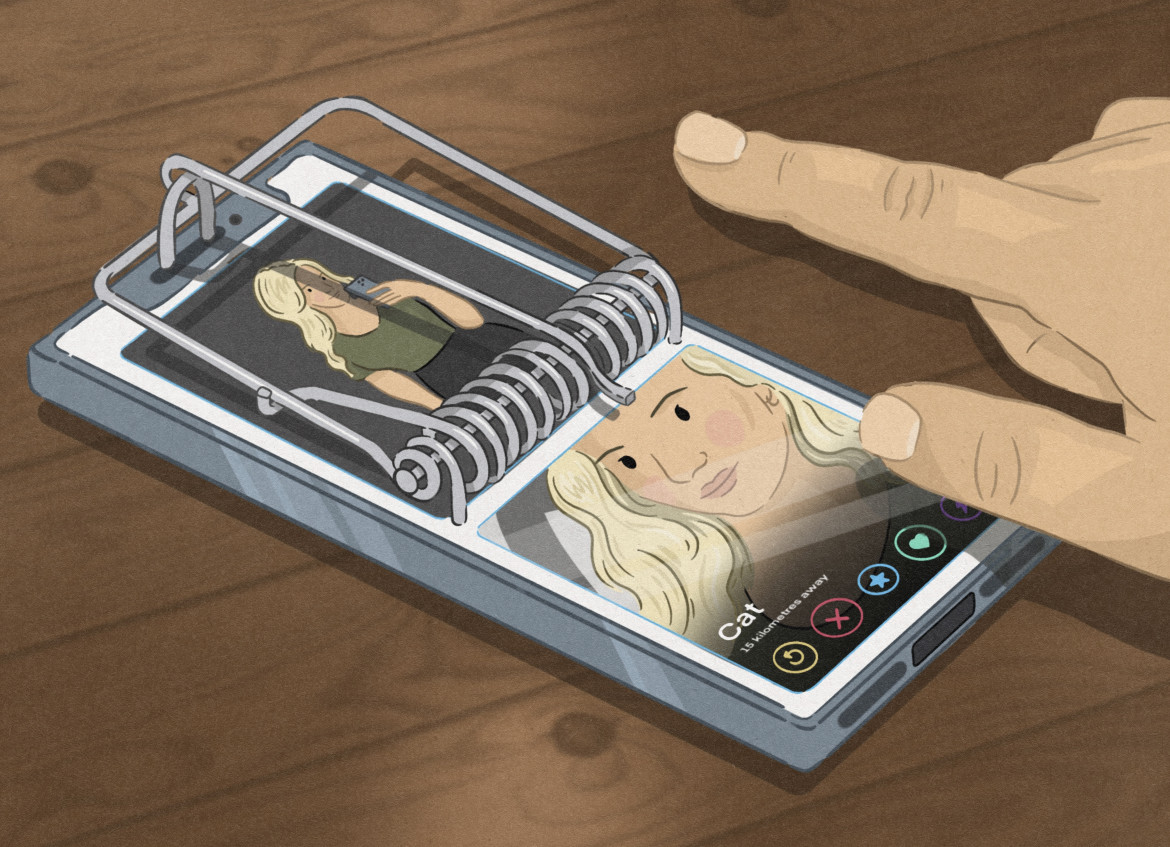

Sembrano domande dal vago sapore filosofico, domande non sempre spontanee, tanto più che chi investe e controlla le società di intelligenza artificiale – che sono più o meno gli stessi gruppi che dominano e controllano le tecnologie che usiamo da anni – da qualche tempo denunciano improbabili rischi per l’umanità in un settore che, lasciato crescere incontrollato, porterebbe alla scomparsa degli umani, delle loro civiltà, sostituite dai robot. Controlli e regole che comunque – l’hanno detto in modo più che esplicito – sarebbero loro stessi a dover ipotizzare e scrivere.

Quindi, ChatGpt quando scrive o risponde a una domanda s’inventa davvero qualcosa di nuovo, mai scritto prima? Oppure mette insieme una serie plausibile di frasi che ha letto da qualche altra parte? Magari le assembla in modo straordinariamente ultra veloce e persuasivo ma sempre da “copione”?

Un Language Model è un sistema che incolla sequenze linguistiche secondo la probabilità della loro combinazione, senza nessun riferimento al loro significato: è un pappagallo stocasticoEmily Bender et al., 2021

Qualcuno sta provando a rispondere a questi amletici quesiti. In modo scientifico. Rigoroso. Il progetto Gdelt, per citare l’ultimo esempio. Che non è un esempio fra i tanti, visto che il gruppo si è dato la missione di monitorare le “informazioni” nel mondo, controllando qualsiasi cosa: rete, tv, giornali, spettacoli, filmati, comunicati. Tutto. E anche se gode di molta autonomia nei suoi lavori, non può certo essere inserito fra gli oppositori delle Big Tech, visto che collabora strettamente con diversi dipartimenti di Google.

A cosa è arrivato questo studio? A un’affermazione semplice semplice: che gli LLM, che i bot come ChatGpt “non creano” un bel nulla. Sembrano al massimo dei bravi “arrangers“, arrangiatori. Ottimi copioni, insomma.

Come si è arrivati a questa conclusione? Con un test complicatissimo da fare ma più facile da spiegare.

I ricercatori hanno rivolto una domanda semplice al bot di Open Ai. Un quesito diremmo da “casalinga di Voghera” su una delle piante da appartamento più diffuse al mondo: “Scrivi un paragrafo su come far crescere bene un giglio della pace”.

La stringa di risposta del bot – una quindicina di righe – è stata più o meno quella che ci si può aspettare: sono piante che portano bellezza, hanno bisogno di luce, vanno esposte a est e via via banalizzando.

Bene, gli studiosi del gruppo Gdelt si sono presi la briga di dividere la risposta in piccole sequenze di parole – tipo “è vantaggioso per i gigli della pace mantenere un ambiente umido” o “vanno posizionati vicino ad una finestra” ecc – ed hanno cercato quante frasi identiche fossero già presenti in rete.

L’hanno fatto usando sul comune motore di ricerca di Google il metodo del Longest Common Subsequence, LCS, che è lo strumento utilizzato dai più svariati studiosi per trovare elementi comuni dentro sequenze di dati. Per capire: lo utilizzano i biologi per trovare correlazioni fra diversi Dna e viene anche usato da alcune università americane proprio per “scoprire” quale testo sia stato scritto dall’intelligenza artificiale invece che dagli studenti.

La ricerca del progetto Gdelt ha così trovato che tutte, ma proprio tutte-tutte, le frasi della risposta di ChatGpt erano già state pubblicate. Da decine di migliaia di volte a diverse centinaia. Tutte le frasi, tutte le sequenze di parole usate erano già state scritte. Da umani. O al massimo – ma è l’unico vaghissimo dubbio che può restare – qualcuna sarà stata scritta da un altro bot, forse proprio da ChatGpt in altre occasioni. Ma si tratterebbe comunque di “plagio del plagio”.

Questo risultato non basta però ad assegnargli una dignità scientifica. Forse l’umanità ha già pubblicato in rete ogni singola frase possibile. Oppure lo stesso test potrebbe essere applicato a un paragrafo scritto da esseri umani. Occorreva quindi una controprova.

Allora il gruppo di studiosi ha prodotto anche questa. Ha preso una notizia della BBC, appena pubblicata, che riguardava l’annuncio di Elon Musk di un nuovo metodo per organizzare gli utenti seguiti su X (i.e. twitter).

L’hanno selezionata appena pochi secondi dopo esser stata pubblicata proprio perché non doveva avere il tempo di essere indicizzata nei motori di ricerca. Anche in questo caso hanno diviso l’articolo in diverse frasi e sono andati a cercare on line se ci fossero corrispondenze esatte.

Ovviamente la sequenza di parole “Elon Musk ha deciso” è stata trovata migliaia di volte. Ma le frasi più complesse, quelle con un significato – “da quando ha acquistato la piattaforma, Musk ha cercato di aggiungere flussi di entrate al colosso dei social media, anche se molti utenti hanno protestato contro i cambiamenti” e le altre – non hanno dato alcun risultato. Non erano mai state pubblicate. Almeno in inglese, almeno in quella sequenza di parole.

Non erano quindi frutto di un copia & incolla, come fa ChatGpt.

Il risultato dello studio del progetto Gdelt non cambia, ovviamente, il dibattito sull’intelligenza artificiale. Il dibattito quello vero, che non riguarda l’improbabile futuro delineato da Musk, Sam Altman e gli altri ma riguarda gli enormi danni sociali che le tecnologie producono già oggi. Adesso.

Non cambia il quadro ma aiuta forse a riportarlo nei giusti binari. Che in qualche modo è anche l’obbiettivo di un gruppo di hactkivist e di artisti che s’è inventato e ha lanciato in rete uno strano software.

La redazione consiglia:

Quell’algoritmo «velenoso» ci difendaIn questo caso si parla dell’intelligenza artificiale addestrata a costruire immagini ed il programma si chiama Nightshade. Proprio come la pianta psicotropa, che quando non uccide provoca allucinazioni. Destinata appunto ad “avvelenare” Dall-E, Midjourney e tutti le altre intelligenze artificiali generatrici di disegni. Accoppiato ad un’immagine, il software – invisibilmente – modifica la descrizione e così quando chiedi all’intelligenza artificiale di disegnare un sole tira fuori un’arancia. E via così.

Neanche questo modificherà la discussione sull’argomento. Ma almeno farà capire che le tecnologie, qualsiasi, anche le più avanzate dipendono esattamente da come le si usa. Da chi le usa.

I consigli di mema

Gli articoli dall'Archivio per approfondire questo argomento