La sfida dell’immaginario digitale

Nel 1928 William Thomas e Dorothy Swaine (Thomas) affermarono la tesi secondo la quale se le persone definiscono delle situazioni come reali, le loro conseguenze sono reali. L’affermazione divenne nota come «Teorema di Thomas» e venne resa popolare dall’idea della profezia capace di autorealizzarsi (self-fulfilling prophecy) di Robert Merton.

Questo concetto costituisce una delle chiavi di volta per comprendere il libro di Helga Nowotny, tradotto in italiano con il titolo, Le macchine di Dio. Gli algoritmi predittivi e l’illusione del controllo (Luiss University Press, pp. 197, euro 19, traduzione di Andrea Daniele Signorelli). L’autrice è esperta dei rapporti tra scienza, tecnologia e società ed è stata tra i fondatori dell’European Research Council (Erc), di cui è stata presidente (2010-2013). Attualmente è professoressa emerita di Science and Technology Studies all’Eth di Zurigo.

IL LIBRO È UN VIAGGIO originale nella politica della tecnologia digitale e dell’intelligenza artificiale, forte delle sue esperienze di ricerca europee e mondiali. Nowotny si smarca infatti da tecnofili e tecnofobi, illustrando opportunità e rischi di affidarsi a tecnologie controllate dalle grandi aziende di big tech.

L’autrice ritiene che abbiamo bisogno di saggezza e di umiltà perché i nuovi strumenti creino benefici all’umanità e per la sopravvivenza del pianeta, contrastando inquinamento e riscaldamento globale. La saggezza è necessaria per comprendere i limiti delle capacità tecniche e non spingerci a delegare tutte le decisioni a dispositivi di cui non conosciamo precisamente spiegazioni e funzionamento. L’umiltà è volta a chiarire l’impossibilità di prevedere il futuro e controllarne le condizioni. Dobbiamo convivere con l’imprevedibilità e l’incertezza di quello che accadrà, mantenendo la resilienza di fronte all’inatteso.

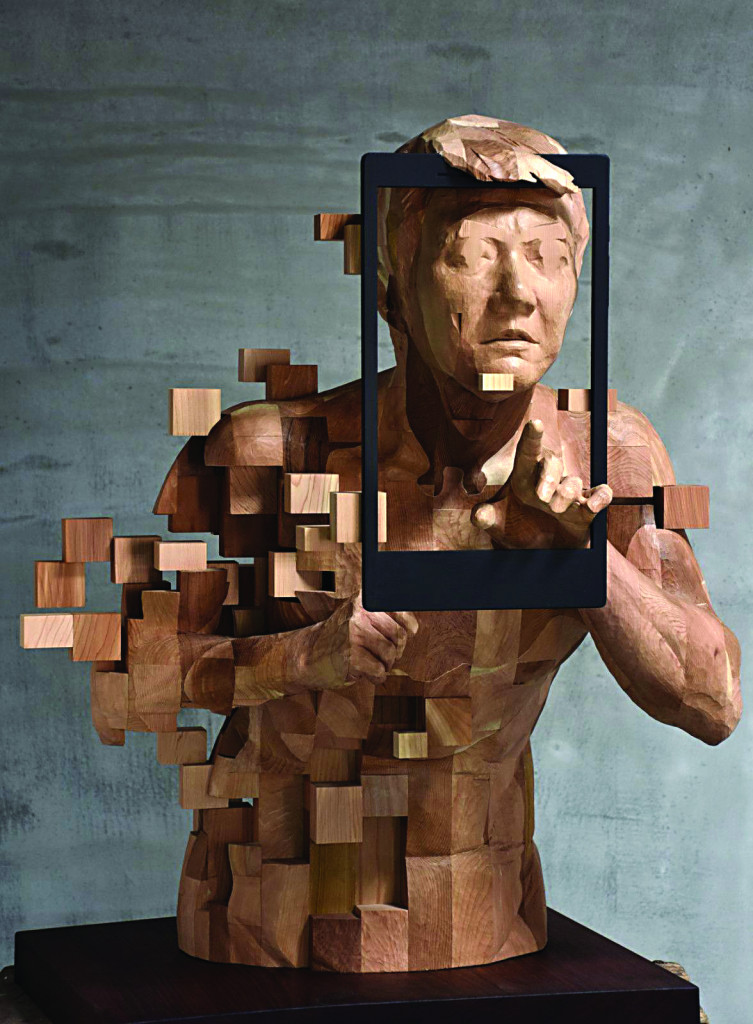

Il rischio principale di cui ci parla questo volume è la perdita di parte della nostra umanità, o meglio, di alcune caratteristiche che negli ultimi secoli abbiamo considerato profondamente umane, cioè la creatività, la nostra identità molteplice, l’idea di avvenire come orizzonte ricco di possibilità inesplorate e ignote. Tutto questo potrebbe essere compromesso dalla scelta di delegare agli algoritmi la capacità di organizzare per noi il futuro e considerare vero e credibile solo quello che ci viene proposto dalle macchine intelligenti: una profezia che si autoavvera.

SIAMO ESPOSTI alla possibilità di compromettere la nostra immaginazione, limitandola a quegli aspetti considerati dalle aspettative degli algoritmi come l’unica realtà credibile. La colonizzazione dell’immaginario è sempre stata l’ambizione delle tecniche mediatiche, ma il digitale, oltre a rappresentare il mondo, si candida a sostituirne le forme, costituendo uno specchio del tutto identico al reale, ma completamente controllabile: una simulazione.

Sappiamo che il funzionamento della razionalità algoritmica si nutre delle correlazioni dei dati del passato intese come anticipazione di ciò che accadrà in futuro. Se l’affidamento alle previsioni è completo e incontrollato, assisteremo a un collasso tra passato e futuro. Il passato con le sue forme, anche discriminatorie, governerebbe le aspettative, che hanno la tendenza ad autoavverarsi, contribuendo a realizzarle.

Già assistiamo a una contrazione del tempo che accelera rincorrendo l’efficienza algoritmica e insieme si immobilizza in una ripetizione senza differenze, o in un presunto presente esteso privo di interruzioni e intoppi.

Peraltro, affidarsi a queste aspettative sul futuro è pericoloso anche per l’incapacità dei sistemi di predizione di anticipare un evento inatteso, come è avvenuto nel caso della pandemia di Covid-19. La capacità di previsione di una pandemia – pure annunciata da tempo – si è scontrata con la mancanza di volontà politica di pianificare le azioni in caso di situazioni sgradite, difficili da gestire.

ANCHE LO SPAZIO è a rischio di collasso a causa della forza del digitale di simulare la presenza anche a distanza. Nella pandemia abbiamo sperimentato questo effetto nel distanziamento, che ha contribuito ad affaticare le nostre giornate, ma ha anche reso possibile una continuità lavorativa, pur nell’impossibilità di incontrarsi, accedendo da remoto ai sistemi di controllo e di gestione di dati e relazioni sociali. Tali circostanze hanno creato una distinzione tra attività che potevano essere svolte senza la presenza del corpo e quelle che non lo permettevano, di solito ritenute di livello inferiore.

Il digitale, quindi, è stato più di una rappresentazione per noi, in quanto ha permesso una realtà alternativa, percettiva e organizzativa. Senza bisogno della realtà virtuale abbiamo addomesticato, nel senso di «reso domestiche», molte attività che prima richiedevano una presenza sui posti di lavoro. Il significato di questa esperienza deve ancora essere colto fino in fondo, e potrebbe avere conseguenze spiacevoli a lungo termine, pur avendo protetto la nostra sicurezza durante le fasi acute della pandemia.

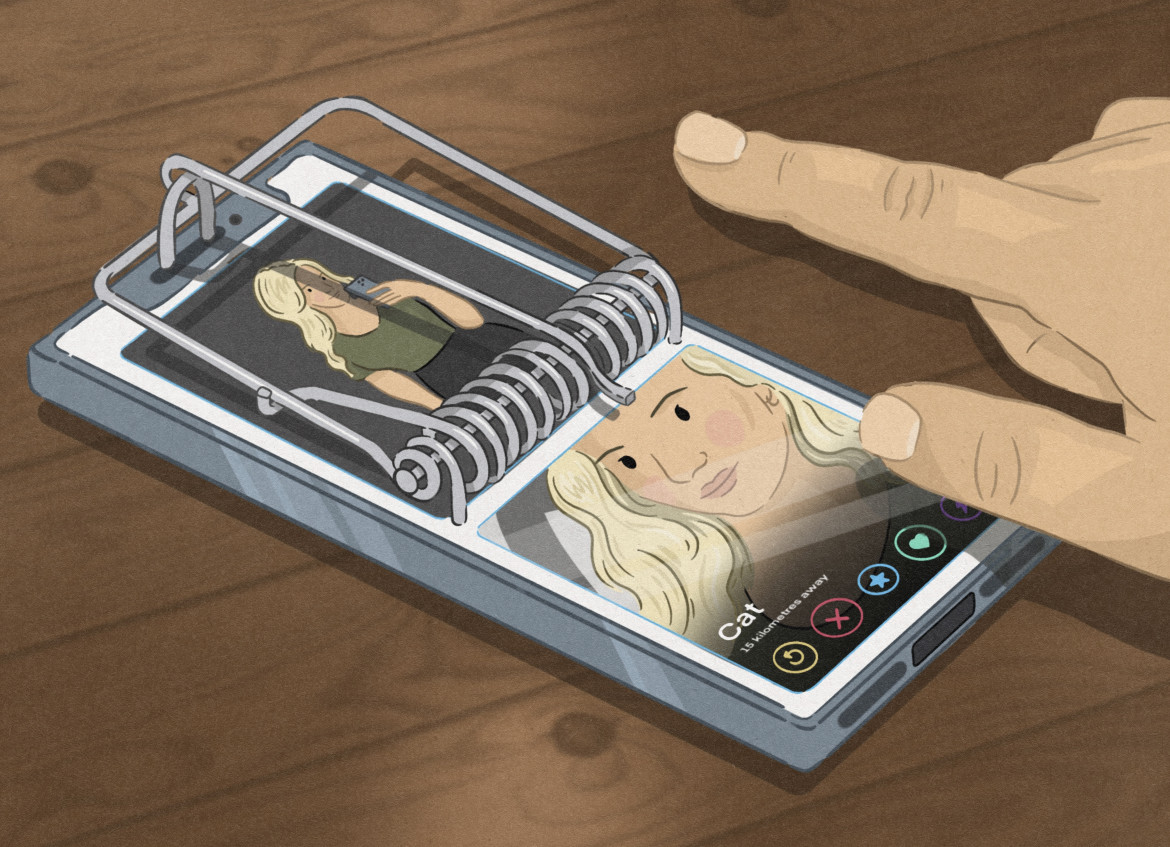

La contrazione di tempo e spazio e l’addomesticamento di una parte della nostra vita, lavorativa (ma anche sociale, persino sentimentale ed erotica) insieme con una malintesa fiducia cieca che ogni innovazione condurrà inderogabilmente al progresso, possono contribuire a creare una strada dal destino infernale, sia pure lastricata di buone intenzioni. Dobbiamo discutere su cosa intendiamo per progresso e condividere i nostri valori con quelli di chi produce le macchine che poi organizzano i nostri processi conoscitivi e vitali, altrimenti potremmo incorrere in contraccolpi inaspettati, senza poterli contrastare.

IL FUTURO RESTA INCERTO anche se cerchiamo di tenerlo sotto controllo. La saggezza dovrebbe aiutarci a limitare la nostra ansia di previsione, ad accettare la molteplicità plurale e imprevedibile degli eventi che accadranno come un’opportunità di trasformazione, senza perdere resilienza, originalità, pensiero critico e propensione all’innovazione.

Le tecnologie digitali, compresa l’intelligenza artificiale, costituiscono dei sistemi sociotecnici a cui contribuiscono anche le persone. La collettività deve prendere parola per decidere come vuole usare questi strumenti e a che scopo desidera adottarli, come avviene per esempio in Giappone coi robot che si occupano di cura delle persone. Oltre all’etica, nella progettazione tecnica è necessario includere le voci di coloro che subiranno le conseguenze degli strumenti che si stanno realizzando.

Si tratta di sistemi politici che prendono decisioni, magari implicite, che hanno effetti concreti su tutte e tutti noi. È urgente trovare sistemi di governo della costruzione di questi dispositivi che siano plurali e democratici. Non possiamo permettere che le tecnologie digitali – che informano le nostre società complesse, sempre in equilibrio instabile – siano progettate in oscuri laboratori privati, geopoliticamente orientati, da scienziati la cui appartenenza di genere e socioculturale è omogenea, oltre che distante dalla nostra. È vitale preservare lo spirito critico come cittadini e come utenti di servizi, che per giunta si basano su dati estratti in modo controverso dalla registrazione e interpretazione dei nostri comportamenti.

I consigli di mema

Gli articoli dall'Archivio per approfondire questo argomento