Rendere il dominio digitale un posto migliore. Il nuovo Online Safety Act introdotto nel giugno 2021 in Australia cerca proprio di raggiungere questo obiettivo, ridisegnando i poteri della Commissione per la sicurezza online e coinvolgendo, in parte, anche i provider. Più o meno nello stesso periodo anche l’Inghilterra ha proposto un regolamento per la “sicurezza di internet”. Come spesso accade la giurisprudenza può essere però un’arma a doppio taglio: se da una parte agire a tutela della vita digitale dei cittadini è sicuramente importante, dall’altra pratiche di controllo all’accesso di Internet e moderazione dei contenuti online possono essere deleteri per alcuni gruppi sociali o per la stessa privacy degli utenti.

Le aree prioritarie della legge, che sarà formalmente in vigore a partire dalla fine di gennaio 2022, riguardano la rimozione di contenuti considerati pericolosi per adulti e giovani come ad esempio i contenuti correlati a pratiche di cyberbullismo o alla condivisione non consensuale di materiale intimo. Cosa sia effettivamente e oggettivamente offensivo della morale e della decenza sia sui mezzi di comunicazione sia nei videogame, il governo australiano lo ripesca dal Codice di classificazione nazionale emanato a metà anni ‘90: scene di sesso non consenziente o che coinvolgono minorenni, utilizzo di un linguaggio violento, abuso di droga, grave incitamento alla violenza.

Nella pratica la legge fornisce delicati poteri investigativi alla Commissione per la sicurezza online la quale, nell’ambito di un’indagine, può ottenere informazioni circa l’identità di un utente su un social media oppure leggere informazioni relative alla persona attraverso le sue email, i messaggi istantanei o le chat. La collaborazione tra governo e aziende tech, così come la possibile decrittazione di comunicazioni private senza la necessità di esibire un mandato, è in sostanza una richiesta alle aziende che forniscono servizi di comunicazione cifrati di poter accedere ai contenuti criptati di un certo utente su richiesta. Il discorso che gira intorno alla possibilità di dare alle forze dell’ordine accesso a materiale protetto da cifratura si riapre spesso, soprattutto nel dibattito eterno che coinvolge la sicurezza pubblica. Ciò che di sicuro sappiamo è che fornire una backdoor alle autorità giudiziarie per contrastare ad esempio i reati pedopornografici mina la sicurezza degli utenti. Un cane che si morde la coda: la necessità di sicurezza in un dato momento non può mettere a repentaglio la sicurezza di tutti, in ogni momento.

L’altra faccia della medaglia

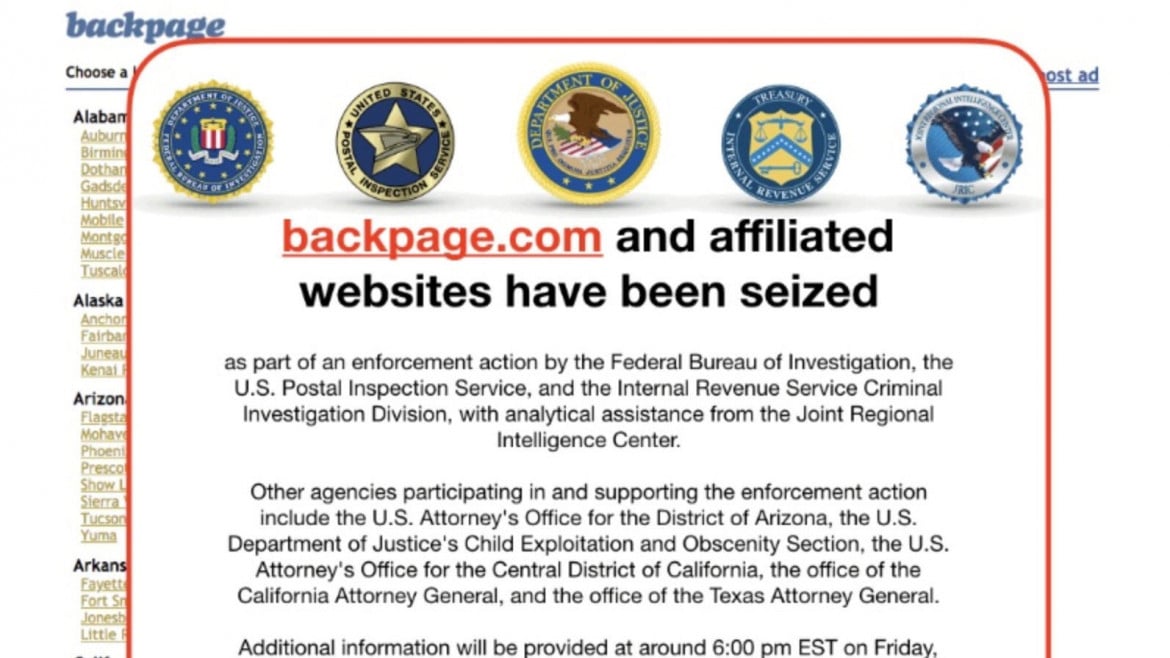

In linea di massima le novità introdotte dall’Online Safety Act sono al passo con le criticità che rappresentano la società onlife in cui ci troviamo immersi, come la creazione di deepfake o la veicolazione di contenuti senza consenso o ancora il cyberbullismo. La possibilità che la legge si trasformi in una replica del caso SESTA/FOSTA scoppiato nel 2018 negli Stati Uniti è però dietro l’angolo. L’esempio è perfettamente calzante poiché la legge che il governo americano voleva promulgare aveva lo scopo di ridurre il più possibile il traffico di esseri umani e la prostituzione infantile. Ma la medaglia ha sempre due facce: sebbene da una parte la chiusura del sito Backpage.com – all’interno del quale i genitori dei ragazzini scomparsi ritrovavano loro stessi i figli e le figlie – sia stata una vittoria, per coloro che sceglievano il sito per prostituirsi volontariamente la legge si è rivelata un grande problema. Da un paio di anni chi si prostituisce ha iniziato ad appoggiarsi infatti sempre di più a siti web, alla ricerca di uno spazio sicuro dove lavorare e che permetta (a volte) di essere tutelati anche dalle piattaforme online.

Quando parliamo dell’Online Safety Act incorriamo in un simile caso. Attraverso la legge la Commissione per la sicurezza online ha il potere di rimuovere contenuti sui social media, su servizi internet, nelle app di messaggistica. Se ai contenuti etichettati come sessuali, che offendono standard di moralità e decenza (creati a metà anni ‘90) aggiungiamo anche tutti i contenuti che non possono essere visionati da un pubblico minore di 18 anni, allora rimane ben poco. Le categorie sono molto ampie, poco chiare e in questi casi le aziende tech – per non incorrere in sanzioni – preferiscono rimuovere totalmente i contenuti senza soffermarsi a comprendere la sottile differenza che può esserci tra l’uno e l’altro. Pensiamo non solo a chi lavora prostituendosi online ma anche a chi crea contenuti pornografici e a coloro che condividono un’educazione sessuale positiva come coach o attivisti e attiviste. Inoltre a parte la possibilità di andare in tribunale (allungando di molto i tempi in caso di rimozione scorretta), non sono chiari gli specifici mezzi di appello per difendersi da una decisione imposta dalla Commissione.

Davanti a un contenuto che vìola i termini la Commissione può richiedere anche l’implementazione di un sistema di accesso limitato in base all’età, una sorta di parental control impostato dallo Stato e non dai genitori. Più in generale, il governo starebbe lavorando anche per creare un sistema obbligatorio di verifica dell’età online. L’associazione Digital Rights Watch, no profit australiana sui temi dei diritti digitali, ha risposto alla consultazione pubblica sulla legge e ha sollevato un paio di criticità su questo punto. Una su tutte l’obbligatorietà di fornire informazioni personali ma anche la possibilità concreta di raggirare facilmente i siti che impongono la verifica dell’età, navigando su altri potenzialmente meno sicuri o come accade in alcuni siti spuntando la casella “dichiaro di avere 18 anni”. Diverso sarebbe invece se il governo obbligasse, come proposto, la verifica dell’identità attraverso sistemi biometrici come ad esempio il riconoscimento facciale. Un’invasione della privacy degli utenti totalmente sproporzionata e che in Europa sarebbe seriamente ostacolata dal Regolamento GDPR, il quale attraverso il principio di proporzionalità precisa la necessità di verificare se esistano altri modi meno invasivi per riconoscere l’età di una persona.

L’impatto su alcuni gruppi sociali

La legge conferisce poteri anche ai provider di servizi Internet che possono essere contattati per bloccare (fino ad un massimo di 3 mesi) domini, URL o indirizzi IP che forniscono l’accesso a materiale violento o sessuale. Come afferma Digital Rights Watch questa è stata la reazione più semplice a seguito dell’attacco terroristico compiuto da un suprematista bianco all’interno di una moschea di Christchurch, nel 2019. In quel caso la strage era stata ripresa e veicolata in live streaming su Facebook e aveva scosso la comunità e il mondo intero. La scelta del governo australiano è semplicistica e trascura le molte e complesse questioni sottostanti a un fenomeno simile. Senza poi contare che in molti casi come in occasione dell’omicidio di George Floyd a Minneapolis nel maggio 2020, il video che ha ripreso gli ultimi istanti prima della sua morte è stato fondamentale per rendere responsabili i poliziotti che lo trattenevano. È stato inoltre miccia esplosiva per la nascita del movimento internazionale Black Lives Matter.

Che cosa possa significare la parola “violento” accostata al termine “contenuto sessuale” è poi difficile da stabilire. Il rischio è garantire accesso ad una sessualità tradizionalmente intesa, oscurando la molteplicità di interpretazioni esistente nella nostra società.

La chiusura di siti web ha un serio impatto sui diritti umani e sul dibattito democratico intorno alle criticità espresse da specifici gruppi di persone. Un esempio recente è la censura praticata ai siti web LGBTIQ+ in sei paesi tra il sud-est asiatico e la Russia: come riportato dall’associazione OONI che dal 2012 misura il livello di censura di Internet nel mondo, spesso le aziende che creano tecnologie per filtrare contenuti (anche) per i governi non necessariamente adottano un’ottica inclusiva. Per questo motivo, come si legge nel report di OONI, una nota azienda tecnologica che produce software di questo tipo ha potuto categorizzare i contenuti prodotti dalla comunità LGBTIQ+ sotto la dicitura “Alternative Lifestyles”. Rimossa nel 2019, la categoria conteneva “l’intera gamma di pratiche, interessi e orientamenti sessuali non tradizionali”.

A conti fatti leggi simili saranno proposte finché il pensiero comune sarà quello di fornire soluzioni semplici a fenomeni complessi. Non esistono backdoor “sicure”: se lo stato australiano intende intromettersi nelle comunicazioni degli utenti deve rendersi conto che anche altri potranno realisticamente farlo. Per non parlare poi della necessità sempre impellente dei governi (e non solo) di tutto il mondo di bandire l’anonimato online al fine di riconoscere e perseguire con maggiore facilità chi si macchia di reati. Una possibilità continuamente smentita – come riporta alcuni mesi fa NBC news – dal fatto che ad esempio il 99% delle persone che esprime insulti razzisti su Twitter non nasconde affatto il proprio nome. Se da una parte sembrerebbe che il mondo online stia diventando una fortezza regolata ancor di più della vita offline, da sottolineare è come leggi di questo tipo dichiarino in maniera esplicita l’abdicazione di responsabilità da parte dei governi nei confronti di un sempre maggiore strapotere delle piattaforme digitali. Ad oggi, sembrerebbe infatti spetti a loro l’ultima parola su cosa sia un contenuto accettabile o meno.