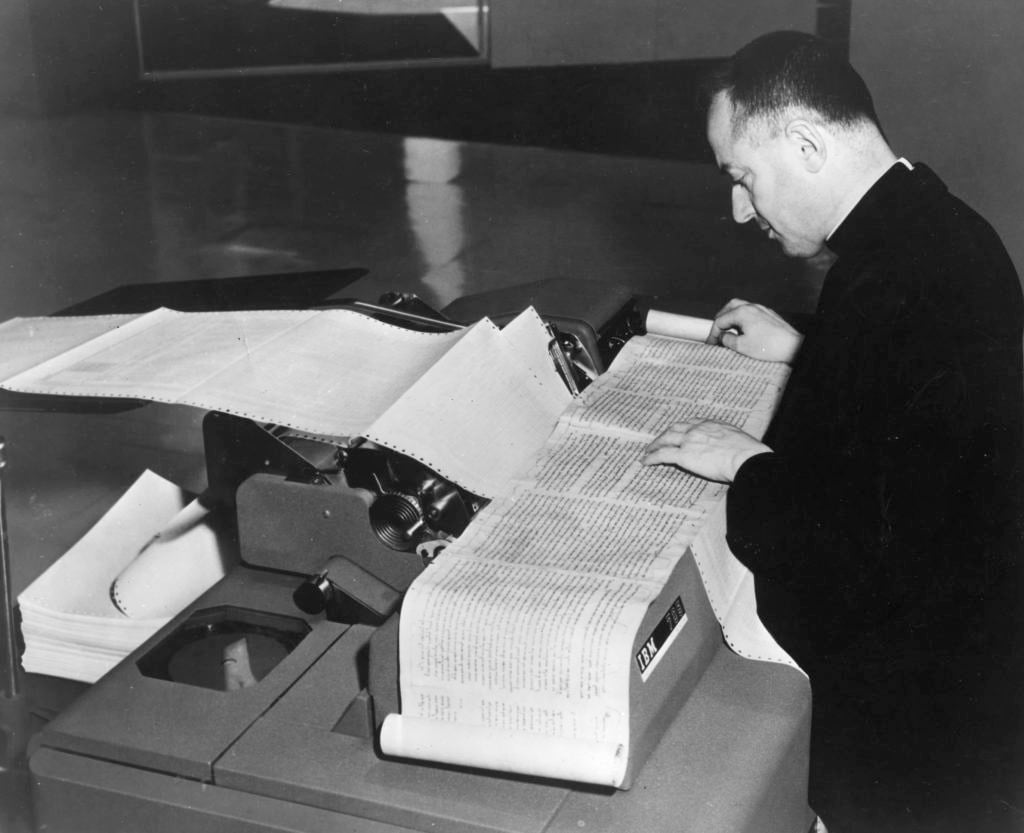

Fra le proposte di nuove lauree in esame al MIUR più d’una riguarda le Digital Humanities, cioè l’applicazione dell’informatica agli studi sociali e culturali. L’approccio tecnologico ai dati umanistici, anzi la stessa concezione di concetti e parole come «dati», dunque gestibili e analizzabili con processi matematici, deriva dagli esperimenti pionieristici di Roberto Busa, il gesuita milanese che negli anni quaranta convinse l’IBM ad aiutarlo nella creazione di una piattaforma per digitalizzare e rendere così indicizzabile e analizzabile l’opera omnia di Tommaso d’Aquino. Dopo un lento progresso sotto traccia, negli ultimi vent’anni – soprattutto da quando tutto il processo di produzione testuale, anche a stampa, è diventato digitale – le DH hanno conquistato una visibilità universale e pervasiva producendo strumenti e metodi che secondo alcuni hanno profondamente modificato lo studio delle letterature, tanto da essere inclusi dal Consiglio d’Europa nel patrimonio culturale da tutelare, secondo altri hanno semplicemente trasferito su schermo e tastiera sistemi e contenuti in uso da secoli e per altri ancora devono anzi essere temute e controllate come cavallo di Troia di una cultura antiumanistica.

Qualunque sia la valutazione che ne possiamo dare, le DH attirano ormai investimenti e progetti in tutto il mondo, generando offerte incessanti di lavoro in tutte le università e biblioteche non italiane, e i suoi convegni, organizzati da associazioni nazionali, continentali e mondiali, coinvolgono ogni volta migliaia di persone distribuite in centinaia di sessioni dedicate agli infiniti percorsi aperti nel settore: edizione di testi, analisi statistica, «big data», archeologia digitale, geografia elettronica, didattica a distanza, creazione e gestione di biblioteche, archiviazione informatica, interazione uomo-macchina nella fruizione dei beni culturali e chi più ne ha più ne metta.

Dopo Busa, la cui opera è continuata a Milano da Marco Passarotti, recente vincitore di un ERC milionario con un progetto di archivi lemmatizzati di opere latine, in Italia la scuola principale si è sviluppata a Roma negli anni ottanta e novanta, con Tito Orlandi, Raul Mordenti, Giuseppe Gigliozzi e i loro allievi, sostenitori dell’impatto dell’umanistica computazionale (come preferiscono chiamarla) sul concetto di «testo», grazie alla necessità, che il computer impone, di formalizzare sul piano logico ogni passaggio della sua produzione: anche se – ammonisce Dino Buzzetti – questo rischia di limitare la rappresentazione della conoscenza agli schemi formali che i linguaggi informatici sono in grado di usare.

Di questa scuola una delle personalità di maggiore spicco è Domenico Fiormonte, che ispirò all’università di Edimburgo uno dei primi portali di edizioni digitali e nel 2003, con Scrittura e filologia nell’era digitale (Bollati Boringhieri), teorizzò brillantemente il passaggio da una visione del testo come dato alla sua concettualizzazione come processo, sia sul piano storico sia su quello analitico: si estendevano così ai testi moderni categorie che alla filologia medievale, soprattutto romanza, erano familiari dopo l’Elogio della variante di Bernard Cerquiglini, che già nei primi anni novanta aveva dato impulso alla cosiddetta New Philology, oggi dominante nella medievistica anglosassone e nordeuropea in contrapposizione al neo-lachmannismo di cui l’Italia è considerata custode autorevole. Fiormonte raccoglie e aggiorna i suoi articoli sull’argomento degli ultimi anni in un vivace libro, Per una critica del testo digitale Letteratura, filologia e rete (Bulzoni, pp. 236, euro 18,00). La prima parte espone le Questioni teoriche sulla codifica del testo, cioè sulle tecniche di rappresentazione digitale, nella quale emerge per fascino intellettuale il capitolo «Testo tempo verità», che tramite un bell’apologo dostojevskiano denuncia la rimozione della dimensione temporale, cioè di una concezione dinamica e mobile del testo, emarginata dall’assetto concettuale inerente alla stampa e valorizzata invece dalla sua gestione informatica.

Ma in quest’ambito il contributo più originale di Fiormonte è il cosiddetto political turn, cioè l’analisi di come la digitalizzazione abbia imposto un «nuovo ordine narrativo» (Paolo Sordi) alla nostra società e di come gli sforzi di imporre determinati standard di codifica internazionali (segnatamente il linguaggio XML e la sua applicazione nel sistema TEI, Text Encoding Initiative) abbiano prodotto un dominio anglosassone nel mondo DH, veicolando surrettiziamente una serie di pregiudizi e privilegi culturali che tendono, anche in modo inconsapevole (ma spietato), a escludere culture con alfabeti non latini e a marginalizzare culture occidentali di lingua non inglese. Fa capo a questo meccanismo non un’intenzione selettiva, ma una opzione pragmatica, che stava già dietro il progetto di padre Busa; nondimeno è importante essere consapevoli degli effetti potenzialmente perversi del processo in atto e predisporre misure alternative. Fiormonte anzi, insieme a Desmond Schmidt, che firma una postfazione in inglese al volume, presenta per lo sviluppo di edizioni critiche un sistema di software indipendente dalla codifica XML-TEI chiamato Multi Version Document, che si comincia ad adottare in alcune università australiane. Nella seconda parte della raccolta si espongono alcuni casi di studio esemplificati su testi moderni, come le Nuove Rane di Luigi Capuana nelle sue fasi redazionali, e contemporanei, come i quaderni preparatori ad Ora serrata retinae, il capolavoro del poeta Valerio Magrelli.

Altri casi, sempre nati dalla fervida attività della scuola romana, sono illustrati nel volume di Daniele Silvi Letteratura transmediale Teoria e pratica della cultura digitale (Bordeaux Edizioni, con autorevole postfazione di Claude Cazalé Bérard, euro 18,00), che raccoglie anch’esso ricerche degli ultimi dieci anni precedute da un’ampia introduzione teorica, più incline qui alle scienze della comunicazione che alla filologia. I case studies sono relativi soprattutto a due casi di stilometria, cioè di analisi quantitativa (e perciò informatica) dei fenomeni letterari: le varianti di racconti di Vincenzo Cerami, codificate e sottoposte ad analisi semiautomatizzata in grado di ricavarne il trend dell’autore e individuare i luoghi più «instabili» della sua narrazione, e le versioni spagnole dei Canti di Leopardi, la cui analisi non solo dimostrerebbe che è in torto il Dante del Convivio quando dice che la traduzione fa sempre perdere il senso stilistico dell’originale, ma ci rivela, comparando versioni di epoche diverse, tendenze, costanti e variabili che a occhio nudo, cioè senza l’ausilio del computer, resterebbero impercettibili; o, se intuite, indimostrabili. Per confermare che le potenzialità degli strumenti digitali creano un’occasione probabilmente unica: non solo, come ha scritto Franco Moretti, per rinnovare i metodi di analisi delle opere letterarie, ma anche per ripensarne lo statuto.

Filologi e computer, da Padre Busa ai software perversi

Digital Humanities. Negli anni quaranta il gesuita milanese digitalizzò con l’IBM tutto S. Tommaso... Domenico Fiormonte e Daniele Silvi affrontano in due libri quel che accade oggi: teoria, prassi, egemonie, esclusioni

Roberto Busa, S. J., ritratto in una foto d’epoca alla Yale University

Digital Humanities. Negli anni quaranta il gesuita milanese digitalizzò con l’IBM tutto S. Tommaso... Domenico Fiormonte e Daniele Silvi affrontano in due libri quel che accade oggi: teoria, prassi, egemonie, esclusioni

Pubblicato 5 anni faEdizione del 28 ottobre 2018

Pubblicato 5 anni faEdizione del 28 ottobre 2018